AI光学显微镜 分辨率提升15.4倍!生物医学活体观测新纪元

【新智元导读】清华大学团队通过 AI for Optics 创新的技术赋能超分辨光学显微镜,成功将活细胞成像体积分辨率提升了15.4倍!这项技术的出现,为研究人员提供了一个拍摄「4K高清电影」级别的精密生命过程的机会,如癌细胞分裂和胚胎发育等,开启了生物医药领域的重大突破。

近年来,以深度学习为代表的智能计算方法,对光学显微镜的发展产生了变革性影响。通过光学成像系统与智能算法的联合优化,可以在极大程度上突破光学系统设计的时空带宽固有局限。

基于光学系统与人工智能的交叉创新,旨在突破性能瓶颈,以三维视角和亚细胞级各向同性分辨率观测动态生物过程,为光学显微成像领域的前沿重要挑战。

近日,清华大学生命学院李栋课题组与自动化系戴琼海团队携手提出了一款全新的「AI+」显微镜:元学习驱动的反射式晶格光片虚拟结构光照明显微镜(Meta-rLLS-VSIM)。通过AI赋能超分辨光学显微镜,硬件软件协同优化,实现了「1+1>2」的成像效果,开启了生物医学活体观测的全新视角。

论文链接:https://www.nature.com/articles/s41592-025-02678-3

在诸多三维光学显微成像技术方案中,光片显微镜(LSM)是当前最适宜进行多细胞、大体积样本三维成像的模态之一。

2014年,诺贝尔化学奖得主Eric Betzig基于传统LSM的基础上发明了晶格光片显微镜(LLSM),并通过与结构光照明(SIM)相结合,创造了晶格光片结构光照明显微镜(LLS-SIM)解决方案。

LLS-SIM能够在结构光照明方向上实现分辨率的极致提升,达到了约150纳米的高精度,这是当前的前沿技术方法之一。然而,LLS-SIM仅能生成单一方向的结构光照明,从而导致空间分辨率的各向异性,未超分辨方向可能会出现畸变的影响,从而限制了对三维亚细胞动态的精准探测和研究。

通过 Meta-rLLS-VSIM 的 AI 与光学交叉创新,实现了 LLS-SIM 一维超分辨能力的三维扩展,既不影响成像速度、光子代价等核心指标,又获得了 XYZ 三个维度的近各向同性成像分辨率,达到了横向 120 nm、轴向 160 nm 的高分辨率,相比于 LLSM,体积成像分辨率提升了惊人的 15.4 倍!

特别地,该工作将元学习策略与系统数据采集过程深度融合,仅需3分钟即可完成从训练数据采集到深度学习模型的自适应部署过程,让AI工具在实际生物实验中的应用达到近乎「零门槛」境界。

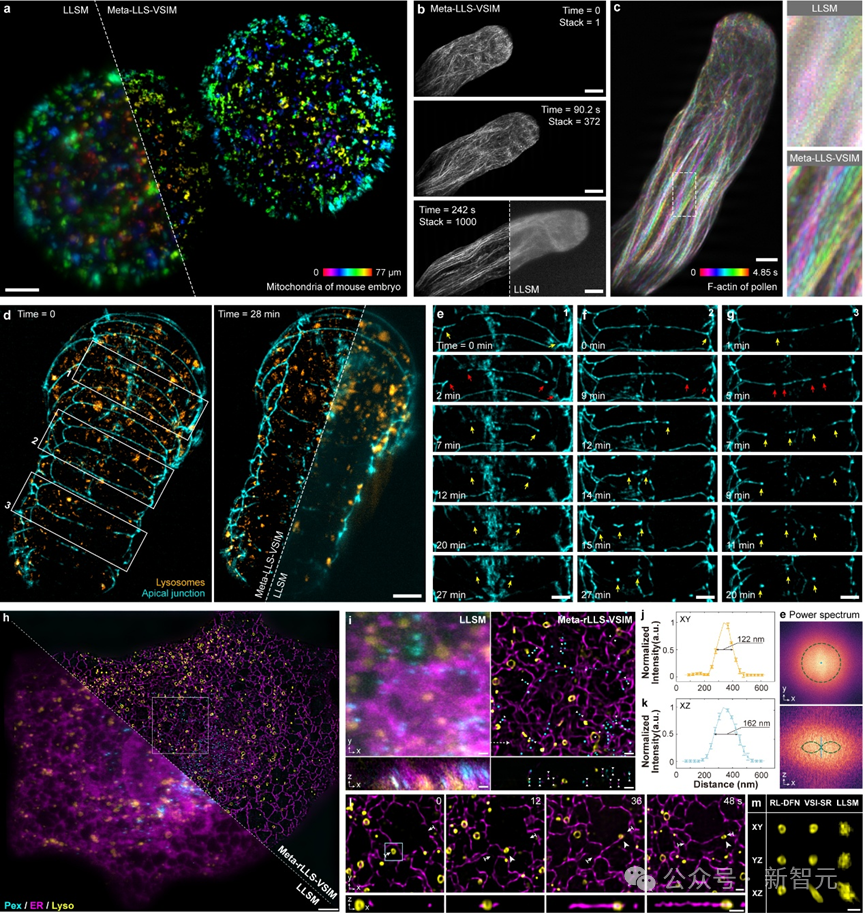

合作团队在植物花粉管、小鼠胚胎、秀丽隐杆线虫胚胎及真核有丝分裂或分裂间期的其他真核生物等多种生物样本上,从单细胞到胚胎尺度,进行了广泛的实验,验证了Meta-LLS-VSIM在快速、长时程、多色三维超分辨成像任务中的出色能力。

Meta-rLLS-VSIM可实现从细胞到胚胎的跨尺度五维活体超分辨观测,打破了传统的观测尺度和分辨率限制,开启了新的可能性在生物学和医学领域的研究和应用。

「虚拟结构光照明」极大地提高了横向分辨率,实现了更加详细、更加精准的图像 Reconstruction。

受限于特殊的双物镜垂直安装的光学系统设计方案,LLS-SIM只能生成固定方向的结构光,而只有结构光照明的方向才能具备超分辨能力。

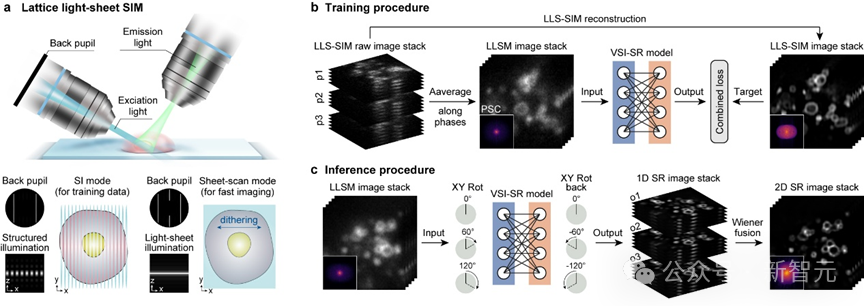

研究团队注意到,由于生物样本生长方向的随机性,LLS-SIM采集到的单一方向超分辨信息实际上涵盖了多个方向上的样本结构特征。因此,如果使用深度神经网络(DNN)可以学习到单一维度超分辨能力,那么就有潜力将其拓展至其他方向。

于是,研究团队运用自主搭建的成像系统,收集了不同生物样本的LLSM/LLS-SIM图像对作为训练集,并培养了一个精心设计的DNN模型,以学习单一维度超分辨能力。

在推理阶段,只需将LLSM低分辨率图像以特定取向输入到深度神经网络(DNN)模型中,就可以获得这一方向分辨率提升的结果。DNN模型就像是一种可以任意改变取向的「虚拟结构光」,从而弥补了LLS-SIM系统的固有缺陷。

最后,通过维纳解卷积等方法将不同方向的一维超分辨图像进行融合,使它们不同方向的超分辨率信息互补,从而获得平面内分辨率一致的各向同性超分辨图像。

虚拟结构光照明超分辨DNN模型:数据采集、训练与推理

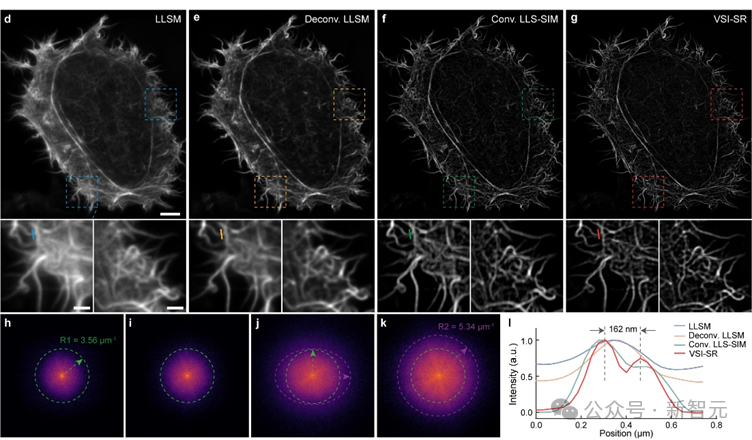

研究团队在亚细胞结构肌动蛋白微丝上测试了虚拟结构光照明成像(VSI-SR)的效果,结果表明,虚拟结构光照明图像具有更高的清晰度,相比于其他方法,VSI-SR在频域上能够捕捉更多的高频信息,同时保持了各向同性。

虚拟结构光照明成像效果展示,通过高分辨率的光学成像技术和先进的计算机算法,精准地重建了物体的三维结构,展现出细腻、逼真的照明效果。

双视角信息融合提升轴向分辨率。

尽管虚拟结构光照明能够拓展LLS-SIM超分辨能力到整个二维平面,但仍无法提高与该平面垂直方向上的分辨率,即轴向分辨率。

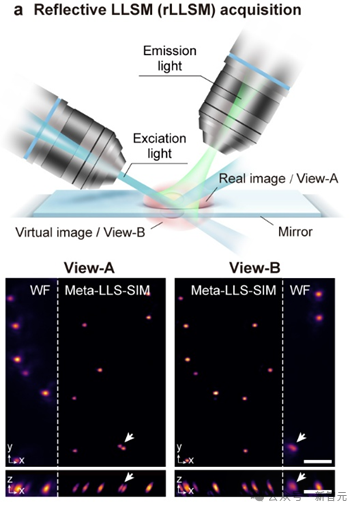

为解决这一问题,研究团队将承载生物样本的盖玻片替换为一个反射镜,从而在进行三维成像时,镜面上方的实像和下方的虚像能够同时被拍摄,并且二者的空间视角不同。

双视角相比单视角,如同双目视觉相比单目视觉,两个视角的分辨率空间取向不同,意味着两个视角的横向与轴向分辨率互补。因此,融合两个视角图像的信息,可以在空间信息采集的本质上,提升轴向分辨率。

基于镜面反射的双视角成像原理,Meta-rLLS-VSIM实现了高-resolution、高速率和高灵敏度的成像技术。

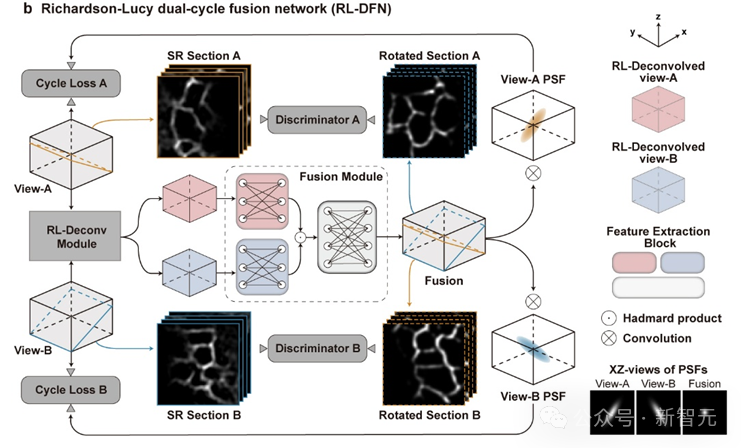

为了更好地融合两个视角信息,研究团队提出了基于光学成像模型启发的Richardson-Lucy双循环融合网络架构(RL-DFN),旨在提高融合结果的准确性和稳定性。

RL-DFN通过融合多视角 Richardson-Lucy 迭代公式,结合可训练卷积层,替代传统的前向和反向传播算子,确保信息融合符合统计学规律的要求,从而提高融合效果。

随后,将融合得到的高分辨率结果与光学系统的点扩散函数(PSF)进行卷积,并与输入图像体栈计算循环损失(Cycle Loss)。这种Cycle Loss将RL-DFN约束为满足物理先验条件的解卷积模型,使轴向分辨率的提升在物理上具有可靠性。

为进一步提升融合结果的保真度,研究团队在RL-DFN设计中引入了判别器,旨在通过判别RL-DFN输出的任意二维切面图与虚拟结构光成像得到的各向同性超分辨平面图,实现RL-DFN与其相互竞争,从而提高融合结果的准确性。

为了欺骗判别器,RL-DFN 会尽力提高信息融合的效果,使得任意方向的切面都能实现各向同性超分辨率, ultimate goal 是在三维空间上实现各向同性分辨率。

RL-DFN的模型结构示意:RL-DFN(Reinforcement Learning-based Dual-Flow Network)模型结构由两个主要部分组成:RL Agent和DFN。RL Agent负责学习RL-DFN的控制策略,DFN则负责生成文本。RL Agent通过与DFN的交互,学习如何控制DFN以生成高质量的文本。RL-DFN的模型结构示意图如下:RL Agent→DFN→文本输出。

在双视角循环Cycle Loss的约束和判别器的对抗下,RL-DFN能够充分发挥双视角互补分辨率信息的优势,合理地提高轴向分辨率。

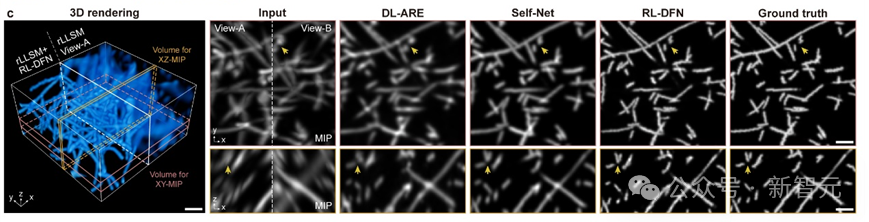

研究团队对RL-DFN与其他无监督方法在仿真数据上的比较发现,RL-DFN能够实现各向同性的超分辨信息融合,且更精确地恢复出样本细节。

RL-DFN与其它方法重建效果对比,结果表明RL-DFN的重建效果优于其它方法。RL-DFN的强大之处在于它可以自动学习并优化重建策略,以适应复杂的数据结构和高效地恢复损失的信息。这种方法可以在多种场景下取得高质量的重建结果,包括对抗式攻击和自然损失等。

元学习实现AI模型的快速自适应部署:元学习是一种机器学习技术,它允许模型学习如何学习,或者说是学习学习的能力。这使得元学习模型能够快速地自适应部署在新的环境中,且能够在新的数据集上取得良好的性能。

在实际生物成像实验中,由于深度神经网络(DNN)的泛化性和表征能力受到限制,通常需要为每一种不同的生物结构、甚至不同信噪比训练专用模型,以获取最佳的模型推理效果。

亚细胞结构成百上千,且形态各异,为每一种结构训练模型需要大量采集训练数据,并消耗大量的计算成本和时间成本,导致AI工具在实际成像实验中难以被广泛应用。

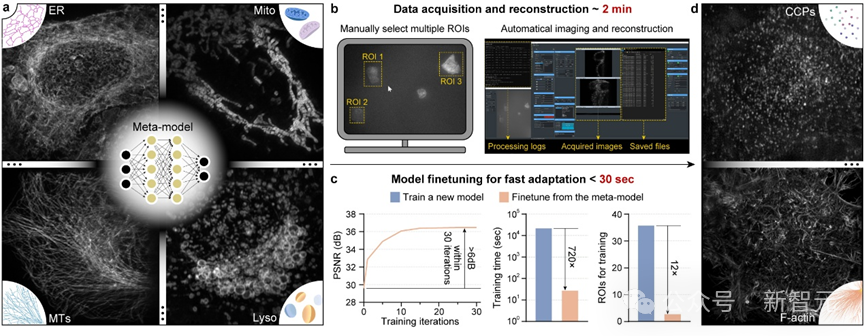

为了解决这一难题,研究团队成功将「元学习」与光学显微系统的数据采集时序深度融合,实现了对模型训练所需数据量的12倍降低和训练时间的720倍缩短,从而开辟了AI模型的快速自适应部署的新路径。

元学习的核心思想是在训练过程中,不仅关注单一任务的性能优化,还旨在使训练模型能够快速地调整自身参数,以实现模型的快速迁移,具备在面对新任务时快速地适应和改进的能力。

通过元学习训练,获得的通用元模型虽然无法在单个任务上达到最佳的推理效果,但是它可以通过在少量子任务数据的少量训练,快速收敛到子任务的最佳模型。通用元模型就像一个「交通枢纽」,拥有到达所有子任务最佳模型的「快速路径」。

在Meta-rLLS-VSIM中,研究团队将不同生物样本和信噪比的超分辨重建问题视为独立的子任务,训练单方向超分辨任务的通用元模型。

在新任务的子任务部署时,只需采集3对高低分辨率图像对,并进行30次微调迭代,就能够快速获得针对该新任务的最优DNN模型。

元学习驱动的模型快速自适应部署实现流程,旨在充分发挥模型的adaptive能力,实时响应业务需求变化。该流程主要包括以下几个阶段:首先,通过元学习算法对模型进行Meta-Training,学习如何学习和更新模型参数;其次,部署模型到生产环境,并实时监控业务数据变化;最后,根据Meta-Training结果,实时更新模型参数,确保模型能够快速自适应部署。

为了简化操作流程,研究团队还在显微镜控制程序上实现了通用元模型部署流程的全自动化。用户只需在图形界面点击几个待采集区域,后续的数据采集、训练集超分辨重建和元模型微调都将在后端自动实现,整个过程仅需不到3分钟时间。

元学习驱动的模型快速自适应部署过程:视频展示

借助元学习构建的"交通枢纽"和全自动化部署流程,研究团队成功实现了AI模型在不同生物样本场景下的快速自适应部署,这项技术的出现大大降低了AI模型在实际生物成像实验中的使用门槛,终于使AI能够真正地辅助生命科学的新发现。

综上,Meta-rLLS-VSIM通过反射增强双视角晶格光片显微镜与元学习快速自适应部署模式的成像系统硬件升级,结合虚拟结构光照明和RL双循环融合网络的人工智能算法创新,展示了软硬件协同优化带来的光学显微镜成像能力巨大提升。

Meta-rLLS-VSIM的出现为细胞生物学、神经科学等基础学科的发展提供了新的技术路径,有望帮助生命科学研究人员从更加全面的多维视角发现、理解和探究丰富多彩的生物现象。

参考资料:

The discovery of a novel genetic mechanism governing the development of complex traits in humans has significant implications for our understanding of disease susceptibility and prevention. By elucidating the regulatory role of long-range chromosomal interactions in gene expression, researchers have shed light on the intricate relationships between genetic and environmental factors that shape our phenotypes. This breakthrough study provides a crucial foundation for future investigations into the molecular basis of complex diseases, ultimately informing the development of targeted therapeutic strategies and personalized medicine approaches.